Jämförelse av transkriberingstjänster för svenska

Det finns många tjänster som erbjuder automatisk transkribering, vi har testat några av dem för att se hur bra de egentligen är på svenska.

Det finns många tjänster som erbjuder automatisk transkribering, vi har testat några av dem för att se hur bra de egentligen är på svenska.

Vi har testat följande tjänster:

- Microsoft Azure Speech-to-Text

- Google Cloud Speech-to-Text

- OpenAI Whisper

- Klang.ai

Testupplägg

Vanligtvis utvärderas modeller på relativt korta ljudfiler, ofta bara ett par sekunder långa. Men i verkligheten så behöver man ofta transkribera ljud som är upp till en eller flera timmar.

Vi har valt ut över 10 timmar ljudmaterial i intervjuformat, där varje intervju varar i upp till en timme. Intervjuerna har olika talare och varierar i ämne. Sedan jämför vi resultatet från de olika tjänsterna med transkriberingar gjorda av professionella transkriberare.

Resultat

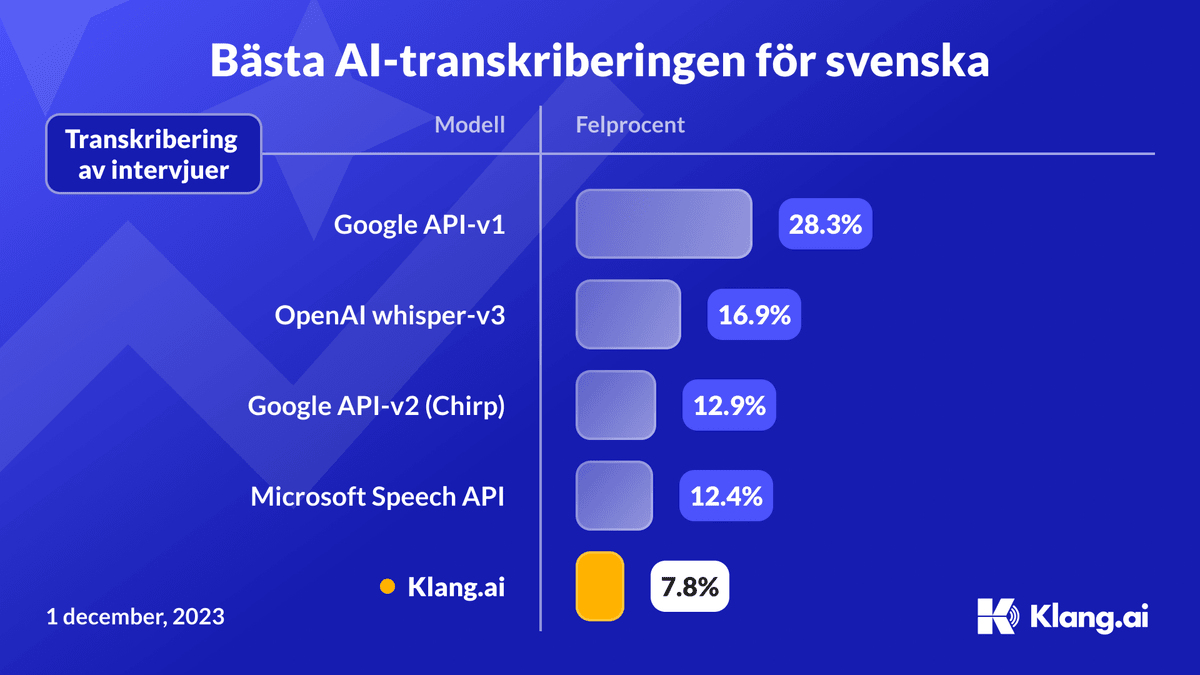

För att mäta hur lika två texter är varandra så använder vi oss av det som kallas Word Error Rate (WER). WER är ett mått på hur många ord som skiljer sig mellan två texter och är ett vanligt mått för att utvärdera transkriberingstjänster.

Det är tydligt att Klang.ai är den modell som presterar bäst med en felprocent på 7.8%! Den är nästan dubbelt så bra som det näst bästa alternativet från Microsoft som hade en felprocent på 12.4%!

Därför är Klang.ai bättre

På Klang.ai har vi lagt en stor del av vårt fokus på just svenska. Det har gjort det möjligt för oss att träna modellen på både mer och bättre data på svenska än de andra modellerna. Svenska är trots allt ett relativt litet språk, så för de stora amerikanska bolagen är svenska inte lika prioriterat.

Detta fokus, tillsammans med vår expertis inom AI och maskininlärning är det som gör att vi kan erbjuda världens bästa modell på svenska!

Varför är OpenAI:s Whisper inte bra nog?

Det pratas mycket om OpenAI:s Whisper-modell som släppts fritt tillgängligt för allmänheten. Det häftigaste med Whisper är att modellen klarar av att transkribera på 100 olika språk, de flesta med relativt bra kvalitet. För att kunna stödja så många språk har de samlat in data från många olika källor, men med varierande kvalitet.

Nackdelen med detta är att OpenAI inte har möjlighet att granska resultaten på varje språk och filtrera bort dåliga transkriberingar från träningsdatan.

Detta leder till ett flertal olika problem med OpenAI:s Whisper:

- Hallucinationer i tysta delar - Modellen skriver ut hela meningar som inte finns med i ljudet, ofta i tysta delar. Detta beror förmodligen på att modellen har tränats på många videos med undertexter, troligtvis från YouTube eller andra video-sajter. Men på dem är det vanligt med instruktionsvideor med beskrivande undertexter helt utan att någon talar, vilket har lärt modellen att skriva ut text när den inte kan höra någon prata.

- Hallucinationer i slutet - Av samma anledning som ovan så skriver modellen ofta ut "Donera till mig på min Patreon", "Textat av någon-undertextnings-tjänst.se" eller liknande i slutet på transkriberingen. Något som ofta står i slutet av texter utan att sägas i videon.

- Tappar bort hela meningar - Modellen är egentligen designad för att hantera ljudsnuttar på upp till 30 sekunder. För att hantera längre filer så gissar modellen hela tiden hur långt in i varje 30-sekunders block den transkriberat, och hoppar med jämna mellanrum fram i ljudet till ett nytt 30 sekunders block. Men det är inte ovanligt att modellen gissar fel och hoppar fram för långt, vilket gör att den tappar bort hela meningar, ibland upp till 30 sekunder i taget.

En stor del av anledningen till att OpenAI:s Whisper är så mycket sämre än de andra modellerna ovan är faktiskt på grund av felen ovan. Om man exkluderar alla hallucinationer och missade meningar blir Whisper nästan lika bra som Googles och Microsofts bästa modeller.

Vi på Klang.ai är stolta över att ha den bästa transkriberingen för intervjuer på svenska och det går att testa kostnadsfritt.